KI-Basiswissen: Grundlagen der KI einfach erklärt

Künstliche Intelligenz kommt bereits in vielen alltäglichen Anwendungen zum Einsatz. Sie funktioniert mithilfe von Algorithmen, die durch maschinelles Lernen Verhaltensmuster und Interessen von Userinnen und Usern erkennen und einordnen können.

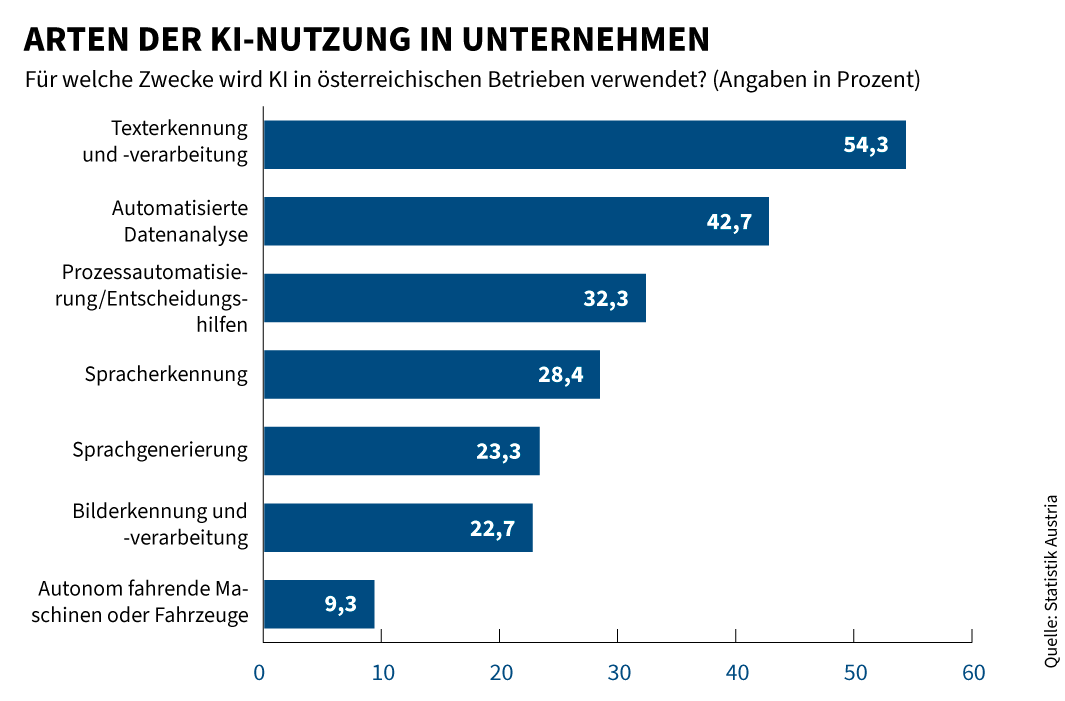

Neuigkeiten zum Thema künstliche Intelligenz (KI) schaffen es beinahe täglich in die Schlagzeilen. Stetig werden die Fähigkeiten und Einsatzgebiete künstlicher Intelligenz erweitert. Auch viele Unternehmen integrieren heute KI-Systeme und Algorithmen in ihre Arbeit: So kombiniert etwa die Austria Presse Agentur ihr Angebot mit der KI-Lösung „CompanyGPT“, um Journalistinnen und Journalisten zu unterstützen, und bereits 60 Prozent der Codes von Microsoft Österreich werden von einer künstlichen Intelligenz geschrieben. Doch was sind die technologischen Grundlagen der KI und warum können Algorithmen Aufgaben bewältigen, die zuvor ausschließlich dem Menschen und seinen kognitiven Fähigkeiten vorbehalten waren?

Der AI Act der Europäischen Union (EU) gibt den rechtlichen Rahmen für den Einsatz und die Entwicklung von KI-Systemen innerhalb der EU vor. Ziele und Meilensteine der österreichischen KI-Strategie wurden in der „Artificial Intelligence Mission Austria 2030“ (AIM AT 2030) der Bundesregierung festgelegt.

Was ist ein Algorithmus?

Als vordefinierte Handlungsabfolgen werden Algorithmen in beinahe allen Alltagsbereichen angewendet. Selbst in Espressoautomaten oder bei der Schaltung einer Verkehrsampel sind wiederkehrende Schrittfolgen von der Umwandlung einer Eingabe zu einer bestimmten Ausgabe zu finden, die einen Algorithmus definieren. Ursprünglich stammt der Begriff aus der Mathematik und bezeichnet eine Problemlösung nach genau definierten Regeln. So kann ein Algorithmus etwa in Form mathematischer Formeln abgebildet oder in natürlicher Sprache – unter Berücksichtigung der Grammatik und Orthografie – formuliert werden. Algorithmische Verfahren weisen folgende Merkmale auf:

- Die Handlung ist vorab bestimmt, klar definiert und ergibt unter denselben Voraussetzungen immer dasselbe Resultat.

- Die einzelnen Schritte sind eindeutig, effektiv, ausführbar und logisch.

- Ihre Abfolge ist endlich, also zeitlich begrenzt und zielführend.

Besonders wichtig sind solche Handlungsabfolgen im Bereich der Informations- und Kommunikationstechnologie. Auch hier bildet ein Algorithmus die Anleitung, nach welchem vorgegebenen Schema ein Programm eine bestimmte Aufgabe auszuführen hat. Um ihn auszudrücken, bedarf es einer Sprache – in diesem Fall keiner natürlichen, sondern einer synthetischen Programmiersprache wie beispielsweise Java.

Der Begriff „Algorithmus“ wird auch häufig im Zusammenhang mit sozialen Medien genannt. Hier filtert der Programmcode den verfügbaren Content einer Social-Media-Plattform, den Nutzerinnen und Nutzer zu sehen bekommen. Ausschlaggebend sind dabei die Beziehung der Userinnen und User zueinander, deren Interessen sowie die Relevanz der Inhalte.

Hier finden Sie eine Auswahl an Artikeln mit weiterführenden Inhalten zu AI-Anwendungen und -Trends:

Was ist Machine Learning?

Ist der Algorithmus erst einmal in einem Programm umgesetzt worden, folgt er also grundsätzlich immer demselben Schema. Mittels Machine Learning kann er jedoch auch darauf trainiert werden, Muster und Zusammenhänge zu erkennen und so selbstständig zu lernen. Ähnlich wie beim menschlichen Lernen greift das System dabei auf Erfahrungen zurück – in diesem Fall sind dies Daten – und erweitert eigenständig seinen Programmcode. Dazu muss der Algorithmus aber von Menschenhand mit Beispieldaten trainiert werden. Der Lernprozess kann in verschiedener Weise stattfinden:

- Unüberwachtes Lernen: Der Algorithmus lernt, aus unbekannten Daten eigenständig Muster herauszulesen, trifft aber keine Vorhersagen für Zielvariablen (angestrebtes Ergebnis, errechnetes Resultat), wie etwa deren Klassifizierung.

- Überwachtes Lernen: Der Algorithmus lernt anhand von bekannten Trainingsdaten, Muster in Bezug auf Zielvariablen vorherzusagen.

- Teilüberwachtes Lernen: Eine kleine Menge bekannter Daten und eine große Menge unbekannter Daten werden genutzt, um den Algorithmus zu trainieren.

- Verstärkendes Lernen: Der Algorithmus lernt nicht mithilfe von Daten, sondern durch ein System von Belohnung und Bestrafung, welche Aktion wann die richtige ist.

Um am Ende eine gute Ausgabe-Qualität zu erzielen, wird der Lernvorgang meist mehrmals wiederholt. Die erlernten Muster können danach vom Algorithmus eigenständig auf unbekannte Datensätze angewendet werden. Nur so kann etwa Instagram seinen Userinnen und Usern neue Inhalte basierend auf ihren Interessen vorschlagen.

Ein Untergebiet des maschinellen Lernens, das sogenannte Deep Learning, geht dabei noch einen Schritt weiter. Es nutzt künstliche neuronale Netze, um komplexe Muster aus großen Datenmengen herauszulesen. Als Vorbild dienen die untereinander verknüpften Nervenzellen des menschlichen Gehirns. Um diese Netzwerke in die Lage zu versetzen, automatisch die Hierarchie von Klassifizierungsmerkmalen in Datensätzen zu bestimmen, werden ihnen diese immer wieder vorgelegt. Die Neuronen-Strukturen, in denen die Verarbeitung der empfangenen Informationen stattfindet, werden mit jeder Wiederholung darauf trainiert, die Daten möglichst präzise einzuordnen. Deep-Learning-Modelle kommen daher mit einem Mindestmaß an menschlichen Trainingseingriffen aus.

Was ist künstliche Intelligenz und wie funktioniert sie?

Die ursprüngliche Form der KI geht bereits auf die 1950er Jahre zurück, diese war vor allem auf Datenanalyse, Mustererkennung und die Vorhersage von Ereignissen trainiert. Grundlage der künstlichen Intelligenz, wie wir sie heute kennen, sind nach wie vor spezielle Algorithmen, jede Menge Daten und Training.

Um moderne KI-Systeme zu entwickeln, müssen diese zunächst mit Beispieldaten (Tabellen, Bilder, Texte, Ton- und Videoaufnahmen) gefüttert und für bestimmte Zwecke trainiert werden. Das zukünftige KI-System lernt in der Ausbildungsphase, Muster in den Trainingsdaten zu erkennen, und passt seine eigenen Einstellungen in Bezug auf die Musterkennung entsprechend an. So werden KI-Systeme anhand von sehr großen Datenmengen in die Lage versetzt, neue Aufgaben zu bewältigen und Entscheidungen zu treffen, die immer treffsicherer werden. Wie effizient das KI-System arbeiten kann, hängt von der Menge und Qualität der Daten ab sowie von der Anzahl von Feedbackschleifen bei Fehlentscheidungen.

Im Jahr 1950 beschrieb Alan Turing, der heute als „Vater der KI“ gilt, in der grundlegenden Arbeit „Computing Machinery and Intelligence“ eine zu diesem Zeitpunkt noch theoretische Maschine, die selbstständig denkt. Nur zwei Jahre später entwickelte der Informatiker Arthur Samuel eine Software, die in der Lage war, eigenständig Schachspielen zu lernen. Und 1956 ließ der Computerwissenschaftler John McCarthy bei der Konferenz „Dartmouth Summer Research Project on Artificial Intelligence“ erstmals den Begriff „künstliche Intelligenz“ fallen.

Eine künstliche Intelligenz, wie sie etwa beim Textgenerator ChatGPT der Entwicklerfirma OpenAI zum Einsatz kommt, wird in der Fachsprache als „generative KI“ bezeichnet. Darunter sind vereinfacht gesagt Deep-Learning-Modelle zu verstehen, die aus Rohdaten neue Inhalte erstellen, die auf den ursprünglichen Daten basieren und ihnen ähnlich sind. Der KI-Textgenerator ChatGPT wurde dafür von seinem Entwicklerteam mit einer Fülle von Daten aus Social Media, Büchern, Online-Foren, News-Artikeln und Spracheingaben gefüttert. Zusätzlich können Nutzerinnen und Nutzer aber auch eigene Inhalte einspeisen und von der KI verarbeiten lassen. So beantwortet ChatGPT etwa Fragen, generiert Texte, übersetzt sie oder fasst Inhalte (auch beispielsweise Video- oder Audiodateien) textlich zusammen – je nachdem welche Eingabeaufforderungen („Prompts“) die KI von der Userin oder dem User erhält. Je spezifischer und genauer die Frage oder Anweisung eines Prompts, desto passender ist die Ausgabe.

Neben der generativen KI existiert auch „prädiktive KI“, die auf Basis historischer Daten versucht, Vorhersagen über zukünftige Ereignisse zu treffen. Dazu analysiert sie Muster und Trends in den ihr zur Verfügung gestellten Datensätzen.

Derzeit ist jede künstliche Intelligenz noch auf jenen Anwendungsbereich in der Arbeits- und Alltagswelt beschränkt, für den sie vorgesehen ist. Sie wird daher als „schwache KI“ bezeichnet. Ihr gegenüber steht theoretisch eine „starke KI“, die vom menschlichen Verstand kaum noch zu unterscheiden sein wird. Eine solche wird bereichsübergreifend arbeiten und dabei eigenständig, flexibel und vorausschauend handeln können. Bislang wurde eine KI mit derartigen intellektuellen Fähigkeiten aber noch nicht entwickelt.

Für den Inhalt verantwortlich: A-SIT Zentrum für sichere Informationstechnologie – Austria